Request description

Bonjour,

J’ai essayé de migrer une application de v5.3.30 à v6.0.3 mais pendant et après la migration je constate plusieurs comportements étranges. J’ai également essayé de faire la migration sur une instance Simplicité vierge avec uniquement le module de Démo et je constate le même comportement.

-

La migration prend beaucoup de temps, 2h dans mon cas pour avoir de nouveau accès à l’IHM.

-

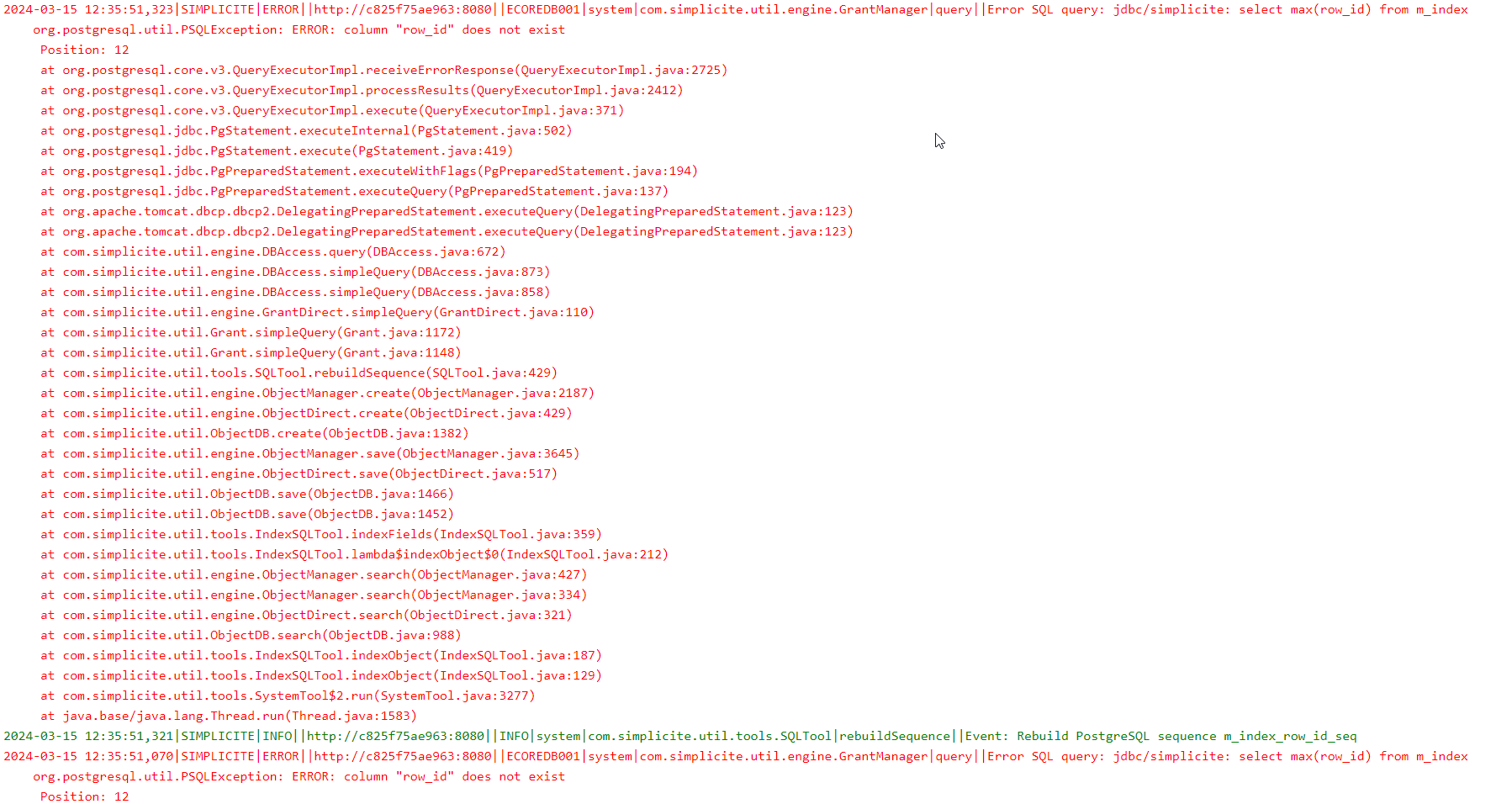

Lors de la migration il y a beaucoup d’erreurs dans les logs.

-

Une fois qu’on a accès à l’IHM, il y a encore beaucoup d’activité dans les logs, des erreurs notamment.

-

Quand je me connecte avec le compte designer, plusieurs domaines et objets ne sont plus accessibles dans le menu. Par exemple, le sous-menu “Objets métier”, “Interface utilisateur” et “Porcessus métier” sont vides.

Est-ce que la migration est toujours en cours même si l’IHM est de nouveau accessible ?

Comment peut-on savoir si la migration est bien terminée ?

Est-ce que la procédure, ci-dessous, que j’ai suivi pour faire la migration est correcte ?

Steps to reproduce

- Créer une instance Simplicité v5.3.30 avec le docker-compose suivant :

version: "3"

services:

db:

image: postgres:13

restart: always

container_name: simplicite_mig_60_2_db

environment:

POSTGRES_USER: simplicite60

POSTGRES_PASSWORD: simplicite60

POSTGRES_DB: simplicite60

ports:

- 6133:5432

volumes:

- ./volumes/db:/var/lib/postgresql

- ./volumes/db/data:/var/lib/postgresql/data

simplicite:

image: registry.simplicite.io/platform:5.3.30

restart: always

container_name: simplicite_mig_60_2_app

environment:

DB_SETUP: "true"

DB_VENDOR: postgresql

DB_HOST: db

DB_USER: simplicite60

DB_PASSWORD: simplicite60

DB_NAME: simplicite60

DB_WAIT: 100

ports:

- 8062:8443

volumes:

- ./volumes/app/git:/usr/local/tomcat/webapps/ROOT/WEB-INF/git

depends_on:

- db

-

Installer le module Démo depuis l’AppStore + faire un clear cache rouge.

-

Arrêter l’instance et supprimer les conteneurs avec la commande “docker-compose down”.

-

Modifier le fichier docker-compose.yml pour utiliser la version 6.0.3.

-

Exécuter la commande “docker-compose up -d”.

-

Attendre 2h et garder un oeil sur les logs.

Remarque : Beaucoup d’erreurs sont présentes.

simplicite_demo_mig_v6_logs.zip (2.4 MB)

-

Après 2h, l’IHM est de nouveau accessible.

-

Une fois connecté avec le compte designer on constate que le menu n’est pas complet.

- Dans les logs il y a encore beaucoup d’activité, principalement des erreurs.

Technical information

Remarque : J’ai également essayé avec une application utilisant une base de données MariaDB.

Instance /health

[Platform]

Status=OK

Version=6.0.3

BuiltOn=2024-03-07 12:50

Git=6.0/e143635330cda547f9c4fcdfc26f38f9283352d2

Encoding=UTF-8

EndpointIP=

EndpointURL=http://c825f75ae963:8080

TimeZone=UTC

SystemDate=2024-03-15 12:51:28

[Application]

ApplicationVersion=1.0.0

ContextPath=

ContextURL=

ActiveSessions=2

TotalUsers=7

EnabledUsers=5

LastLoginDate=2024-03-15 12:08:14

[Server]

ServerInfo=Apache Tomcat/9.0.86

ServerType=WEB

ServerActiveSessions=2

ServerSessionTimeout=30

CronStarted=true

[OS]

Name=Linux

Architecture=amd64

Version=5.15.0-89-generic

DockerImageName=almalinux9

SystemEncoding=UTF-8

[JavaVM]

Version=21.0.2

Vendor=Eclipse Adoptium

VMName=OpenJDK 64-Bit Server VM

VMVersion=21.0.2+13-LTS

ScriptEngine=rhino

ScriptEngineVersion=Rhino 1.7.13 2020 09 02

HeapFree=80337

HeapSize=313344

HeapMaxSize=2033664

TotalFreeSize=1800657

[Cache]

ObjectCache=322

ObjectCacheMax=10000

ObjectCacheRatio=3

ProcessCache=322

ProcessCacheMax=10000

ProcessCacheRatio=3

APIGrantCache=0

APIGrantCacheMax=1000

APIGrantRatio=0

[Database]

Vendor=3

VendorName=postgresql

ProductName=PostgreSQL

ProductVersion=13.14 (Debian 13.14-1.pgdg120+2)

DriverName=PostgreSQL JDBC Driver

DriverVersion=42.7.2

DBDate=2024-03-15 12:51:28

DBDateOffset=0

DBPatchLevel=6;P00;670c794129f408f5bf771ff357b38321

UsingBLOBs=true

[Healthcheck]

Date=2024-03-15 12:51:28

ElapsedTime=20